Alles in allem ist Dein Beispiel ja noch harmlos...

Diese "KI"s (z.B. "ChatGPT") sind "Sprachmodelle", keine "Wissensmodelle".

Sie beantworten Fragen nicht in der Art, dass sie auf irgendeinen "Wissens-Pool" zurückgreifen, aus dem sie dann die inhaltlich korrekte Antwort hervorzaubern.

Stattdessen generieren sie einen Text, der aus der Wahrscheinlichkeit gebildet wird, mit der in der (deutschen) Sprache ein bestimmtes Wort auf ein vorheriges Wort folgt.

Insofern sind die Antworten von ChatGPT oftmals sprachlich sehr perfekte Texte, die aber inhaltlich totaler Mumpitz sind.

ChatGPT kennt nicht die Bedeutung der Begriffe, es kennt nur die Wahrscheinlichkeiten, mit denen sie in einem bestimmten Kontext auftreten.

Die Antworten werden bei jeder Abfrage neu generiert, was dazu führt, dass man auf ein und dieselbe Frage oftmals mehrere sehr unterschiedliche Antworten erhält.

Und oft ist eine richtige Antwort gar nicht dabei.

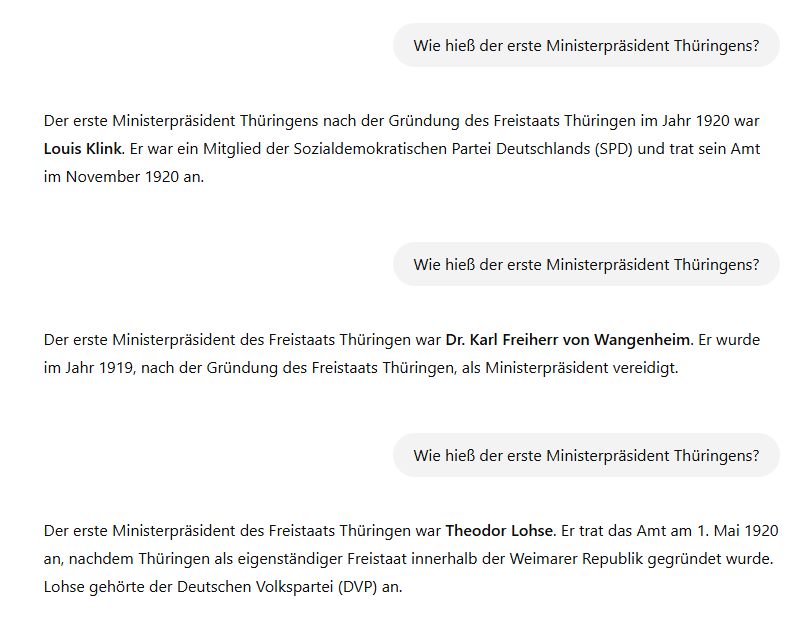

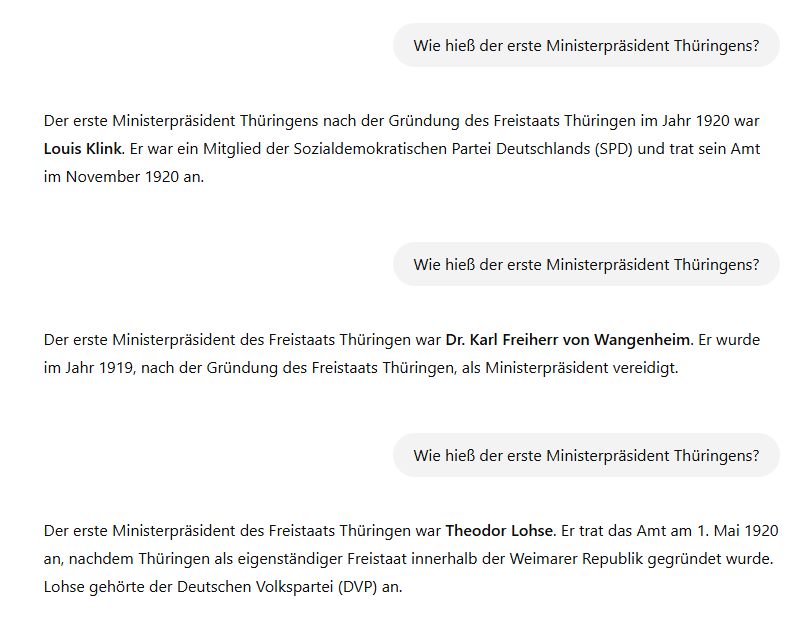

Ich hatte neulich schonmal in einem anderen Thread dieses Beispiel gepostet:

Ich habe ChatGPT drei mal die selbe Frage gestellt und drei verschiedenen Antworten bekommen. Keine der Antworten war richtig.

Wenn ChatGPT etwas mit "Intelligenz" zu tun hätte, würde das Modell selbst dafür sorgen, dass nicht jedes Mal eine andere Antwort gegeben wird. Aber da es die richtige Antwort gar nicht kennt, generiert es jedes mal (frei erfundene) neue Antworten, weil dann die Wahrscheinlichkeit steigt, dass irgendwann doch mal das Richtige dabei ist.

Also man kann solche Systeme ohne Bedenken als "KD" bezeichnen, nämlich "künstliche Dummheit".

Merken wird das allerdings nur jemand, der sich mit den angefragten Sachverhalten auch selbst auskennt. Alle anderen nehmen die Antworten einfach für bare Münze und glauben ChatGPT jeden Sch...ss.

Eine Zeit lang gabe es ja die Befürchtung, dass sich Schüler komplette Hausarbeiten von so einer KI schreiben lassen. Viel Spaß!

Den Lehrern wird es nicht schwerfallen, diesen Unfug auch als solchen zu erkennen und das Ganze entsprechend zu bewerten. Nur die Schüler, die sowieso schon etwas zum Thema wissen, können evtl. auch von den Antworten von ChatGPT profitieren.

Übrigens ist der Microsoft Copilot wesentlich zuverlässiger. Da bekommt man gelegentlich tatsächlich zutreffende Antworten.

Das Problem bei all diesen Sprachmodellen: Mann weiß halt nicht, ob das System jetzt im Moment gerade lügt oder vielleicht doch die Wahrheit abliefert.

Alles in allem sind das Tools, die genau in die heutige Zeit passen: Gefühlte Wahrheit ersetzt harte Fakten und (fast) alle sind zufrieden.

Die perfekte Sprache suggeriert, dass auch der Inhalt perfekt sein sollte, was aber nicht der Fall ist.

Die kontinuierliche Verblödung nimmt ihren Lauf...

Im Zweifelsfall liefert jede simple Suchmaschinenabfrage inhaltlich viel bessere Informationen als ChatGPT. Evtl. muss man aber die Antwort noch in eine sprachlich perfekte Form bringen, bevor man sie dem Lehrer gibt.