Entmündigung

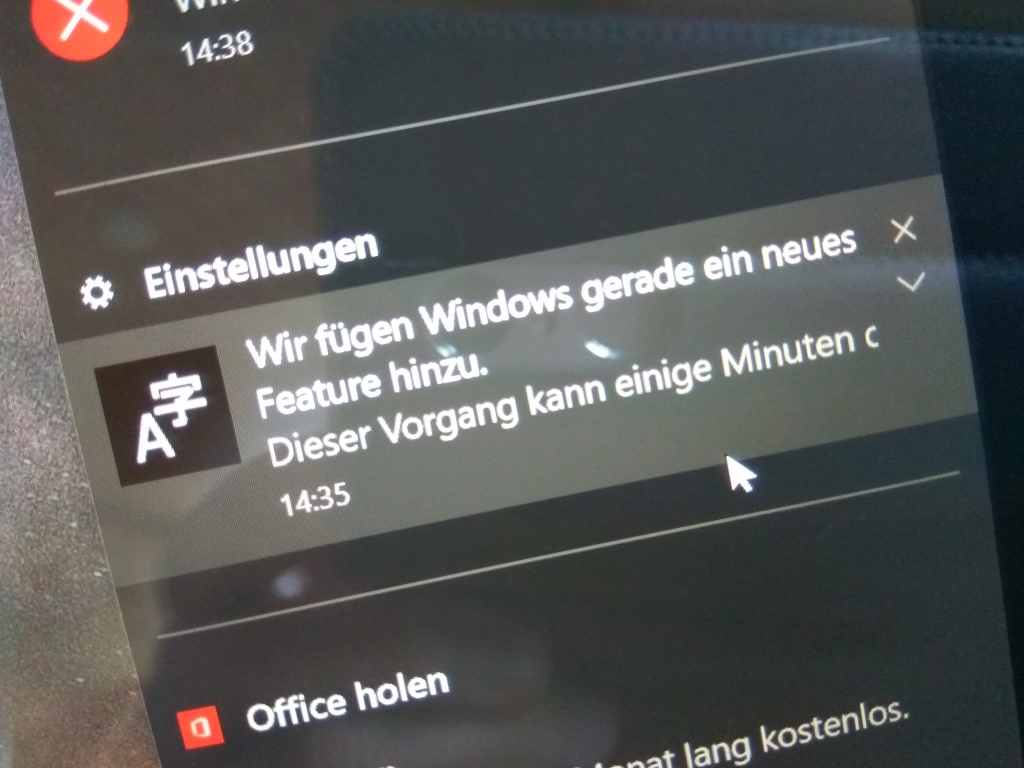

Irgendwie muss ich mich gerade mal wieder daran erinnern, dass man bis einschließlich zu Windows XP den Dienst "Geplante Tasks" ohne Probleme abschalten konnte. Bei Windows 10 besteht für den Administrator im normalen Modus für gewisse Dienste jedoch keine Möglichkeit, diese zu beenden oder gar zu deaktivieren.

Ich als Besitzer des Geräts kann der darauf installierten Software, welche ich ebenso als Lizenz besitze, somit nicht hinreichend Befehlen, was sie zu tun und zu lassen hat. So etwas ist eigentlich nur dann zu tolerieren, wenn es sich um sicherheitsrelevante Bereiche in der Anlagensteuerung handelt. Bei einem Werkzeug wie einem allgemeinen Computer hingegen muss es immer ein sudo geben und die Sache hat erledigt zu sein.

Im Hinblick auf Windows 10 ist zu attestieren, dass ein geplantes Nutzungszeitfenster von maximal zwölf Stunden, ebenso wie der Systemsteuerungs-Dualismus, nicht unbedingt seriös rüberkommen. Aber das sind oberflächliche Probleme, die sich eigentlich recht einfach beheben lassen. Seit XP ist 10 die erste Ausgabe, welche keinen behäbigen Eindruck mehr macht: Die Grundlage des Betriebssystems ist sehr solide und performant geworden. Schön wäre es allerdings, wenn mehr alternative Öberflächen für Windows erhältlich wären: Die Möglichkeit, sich von der (ehemaligen?) Schreckenszentrale "explorer.exe" zu lösen, hat bei Windows theoretisch schon immer bestanden.

Ressourcenverschwendung

Das System selbst hat eine Menge an geplanten Aufgaben, die anhand gewisser Startkonditionen ausgeführt werden, wie Beispielsweise der Idle-Condition. Nicht zu vergessen ist selbstverständlich der integrierte Virenscanner, welcher manchmal einfach einem unbeherrschbaren Such/Updatezwang unterliegt. Alternativen hierzu sind selten besser. Hinzu kommt mittlerweile für fast jede installierte Software ein eigener Eintrag zum Update der solchen.

Unabhängig ob es sich um System-Interne oder Drittanbietertasks handelt, kann deren rigorose Ausführung abhängig vom Nutzungsszenario aus einer SSD eine gefühlte HDD aus Mitte 2000 machen. Selten vergehen Nutzungsstunden, ohne dass irgendein Dienst im Hintergrund irgendetwas machen "muss".

Ein Schalter, welcher dem System mitteilt, dass eine kurze Pause eben keine Idle-Condition zum Start irgendeiner geplanten Aufgabe darstellt, wäre prinzipiell recht einfach zu implementieren. So einfach wie dem System Caffeine zu geben ist es allerdings dann doch nicht. Wenn also jemand gerade den entsprechenden Registry-Key zur Hand hätte, wo die systemweiten Bedingungen an Idle-Conditions definiert sind, würde ich mich sehr über eine Rückmeldung freuen.

Sehr erfreulich sind auch solche Situationen, in denen man auf einen mobilen Hotspot zurückgreift (anstelle von x einzelnen Simkarten): Diese Hotspots bieten oftmals keine hinreichende Möglichkeit zur Verbrauchserfassung bzw. zur Unterbindung ungewollter Kommunikation. Sobald ein modernes Betriebssystem dann das WiFi riecht, werden alle Aufgaben wie gewöhnlich, volles Rohr, durchgeführt. Wären die Softwareanbieter mit den TK-Anbietern verbandelt, so könnte man ein verschwenderisches Datennutzungsverhalten mit marktregulierenden Maßnahmen bekämpfen. Da dem nicht so ist lässt sich übermäßige Datennutzung nur mit Ignoranz in der Entwicklung erklären.

Ganz vergessen hatte ich ja diese ganzen tollen Synctools der Cloudspeicheranbieter: Selbstverständlich ist es normal dass eine Anwendung, die technisch gesehen nichts weiteres ist als ein verpackter rsync, dauerhaft um die 100MB sowie am liebsten einen ganzen eigenen Prozessor in Anspruch nimmt. Besonders schön ist es dann, wenn sich irgendwann herausstellt, dass zur Darbietung von Features mit diskutierbarem Nutzen trotz deren Deaktivierung dauerhaft weitreichende und somit potentiell gefährliche Berechtigungen für die Anwendung hinterlegt werden. Warum brauchen eigentlich so viele Programme, welche prinzipiell rein auf der Benutzerebene ablaufen, administrative Berechtigungen bei der Installation oder gar dauerhaft einen eigenen Dienst? Genauso wie animierte Webinhalte aufgrund unsicherer Wiedergabesoftware gefährlich sein können, so können im Allgemeinen alle Nutzerdaten gefährlich sein und sollten daher vorsichtshalber nur von Prozessen mit beschränkten Zugriffsrechten gehandhabt werden!

Leider ist es nicht möglich, Ressourcenverschwendung bei Computern hinreichend auf einzelne Anwendungen zurückzuführen. Allerdings hatte ich irgendwann auch mal eine Bachelorarbeit durchgelesen, in der die Unterdrückung von Werbung beim Surfen zu einer messbaren Stromersparnis geführt hat. Ich selbst hatte aus versehen einmal die standardmäßig eingestellte Startseite des standardmäßig eingestellten Webbrowsers unter einem frisch installierten Windows 10 durchladen lassen - und bin nach einem Blick in den Taskmanager, Stichpunkt Speicherverbrauch, fast vom Stuhl gefallen.

Gerne rechne ich bei den Kraftstoffpreisen die Ökosteuer heraus: Wie viel kostet das eigentliche Benzin? Wie viel Geld bezahle ich neben meiner jährlichen KFZ-Steuer dafür, dass die Straßen in Ordnung sein sollten?

Genauso wäre es doch eine super Idee, wenn man hinreichend präzise bestimmen könnte, wie viele Ressourcen durch Prozesse verbraucht werden, welche nicht zur Erfüllung der Aufgaben des Nutzers beitragen, sondern ausschließlich den wirtschaftlichen Interessen des Anbieters dienen, um genau diese Verschwendung den Dienstanbietern in Rechnung stellen zu können. Im Klartext sehe ich es nicht ein, warum der übermäßige Einsatz des vergleichsweise ineffizienten Javascript durch Webseiten meine Zeit und meinen Strom kostet.

Ebenso verstehe ich es einfach nicht, warum moderne Browser des Öfteren Probleme mit der effizienten Verwaltung von Webprozessen haben: Während ich auf einem mobilen Einkerner aus 2005 unter XP auch gerne mal hundert Tabs offen hatte, wird es heute trotz neuerer Hardware bereits ab ca. 70 Tabs eng. Kein Wunder: Jedes Tab erhält heute ja seinen eigenen Prozess, welcher ohne nennenswerte Überwachung im Hintergrund einfach weiterläuft. Allerdings sollte es doch bei korrekter Implementierung von Nebenläufigkeit de facto nie zu Aufhängern in der Oberfläche kommen, wenn ich mich recht an die CS-Zweitsemestervorlesung erinnere.

Im Vergleich gesehen

Ist leider eine überwältigende Ignoranz der "großen" kommerziellen Anbieter im Hinblick auf Personen ohne Hochgeschwindigkeitsanbindung festzustellen. Interessant ist insbesondere, dass das erforderliche Übertragungsvolumen moderner Betriebssysteme und Anwendungen teilweise schneller wächst als die verfügbare Bandbreite in durchaus als "modern" zu betrachtenden Regionen der Welt (zu Beachten sind mittlere erforderliche Übertragungszeit und ggf. Volumenpreise!). Wenn man nun die preisliche Entwicklung im Postversand betrachtet, so ist es in manchen Regionen der Welt derzeit durchaus nicht unwirtschaftlich, sich seine Updates einmal im Monat auf Scheibe per Post zukommen zu lassen. Vielerorts freut man sich nämlich mangels brauchbarer Landline darüber, ein ganzes GB im 3G-Netz für "nur" umgerechnet 10€ zu erhalten (Nach Wechselkursumrechnung ist das verglichen mit dem länderspezifischen Durchschnittseinkommen durchaus nicht wenig!). Die Verfügbarkeit eines preislich adäquaten Internetzugangs mit hinreichender Bandbreite ist maßgeblich abhängig davon, ob der TK-Markt in dem entsprechenden Land hinreichend reguliert wird. In Deutschland ist man da mittlerweile recht weit. Aber die Menschen aus jenen Ländern mit teurem Internet werden durch die massive, rücksichtslose Fokussierung auf Internetdienste in ihrem Nutzungserlebnis, und somit in Ihrem Potential bei der Nutzung moderner Technologien, eingeschränkt. Ich finde das unfair.

Stellen wir es einmal anders dar: Wenn in Deutschland in 2016 noch die Hälfte des Umsatzes der Musikindustrie von der Scheibe kommt, obwohl Musikdownloads über das Internet technisch gesehen schon seit mehr 16 Jahren machbar sind, dann muss man sich Fragen, ob dies maßgeblich durch die Präferenz der Verbraucher über das Speichermedium gekaufter Inhalte beeinflusst ist oder durch reale Nachteile bei der Nutzung von nicht-offlinefähigen digitalen Inhalten (Stichwort: Kopierschutz) bedingt wird. Vor diesem Hintergrund mag einem ein halbes Lachen und ein halbes Weinen im Gesicht stehen, wenn man archivierte Pressemitteilungen mit Aussagen aus der Medienindustrie zum Thema Streaming liest: Fehlender Mut zur Modernität und paranoide Angst vor Piraterie hat sowohl Anbietern als auch Nutzern seit Jahren geschadet. Für jedes eröffnete, "legale" Streamingportal existierte bereits seit Jahren irgendein "illegales" Portal, welches zumindest denselben inhaltlichen Umfang geboten hatte. Und auch heute noch gibt es für jedes existierende, "legale" digitale Medienangebot mindestens ein "illegales", zumeist kostenloses Angebot, welches abseits qualitativer Kriterien aufgrund größerer inhaltlicher Vielfalt oder aufgrund fehlender Einschränkungen in der Nutzung als mindestens gleichwertig anzusehen ist.

Ich persönlich habe mir einen Nano mit IR-Diode gebastelt, damit mich Netflix nicht immer fragt, ob ich noch zuschaue. Um meine Inhalte ohne übermäßigen Aufwand synchron in Küche und Esszimmer sehen zu können, habe ich letzen Endes im Jahre 2016 auf eine 1987 eingeführte Schnittstelle von Big Blue zurückgegriffen. Das Umschalten zwischen Medienquellen dauert hierbei interessanterweise nur halb solange wie bei der aktuellen höchauflösenden Medienschnittstelle. Wie schön war das noch als die alten Röhren-TVs innerhalb von einer halben Sekunde den Kanal gewechselt haben!

Aber ist es nicht unfair, dass jene Verbraucher, die nicht über das erforderliche Know-How oder Geld verfügen, der Nutzungsdoktrin von Anbietern schutzlos ausgeliefert sind?

Kopierschutzmaßnahmen sind aufgrund hinreichender Sicherheit des Auftretens von Problemen bei der Nutzung durch berechtigte Personen als disnützliche Produktattribute anzusehen. Nicht-Kopiergeschützte Inhalte müssten demnach teurer sein oder andere Nachteile mit sich bringen. Back to basics wäre ein 1000facher Scheiben-Wechsler in Schrankform langfristig eigentlich gar keine so schlechte Idee!

Insgesamt

Ist an der Response zum ursprünglichen Beitrag bereits zu erkennen, dass sich unter den hier aktiven Nutzern eine vermutlich nicht vollständig aufzuklärende Lücke in der gespürten Effizienz der individuellen Installationen desselben Betriebssystems findet.

Für eine so weitreichende Entscheidung wie der Wahl des Betriebssystems sollte man seine persönliche Frustrationsgrenze gut kennen und sorgfältig abwägen. Die Aussicht, dass irgendwann in der Zukunft einmal alle Probleme weggepatcht sein werden, ist heute wenig hilfreich. Die Frage ist somit eher, wie viel persönliches Know-How man sich langfristig aneignen möchte, um sich auf absehbare Zeit die üblichen Querelen bei der Computernutzung vom Hals zu halten - die meisten Probleme sind sehr individuell aufgrund der vorliegenden Hard- und Softwarezusammenstellung. Prinzipiell einfache Prozesse werden für den geübten Anwender auch heute noch regelmäßig zur Geduldsprobe - und für den unerfahrenen Anwender zum Fiasko. Zwar ist seit Anfang des laufenden Jahrtausends ein Trend der Besserung zu erkennen - der Tag allerdings, an dem mir die nächste wirklich abgerundete, vollständige Software vor die Nase kommt, wird garantiert rot im Kalender angekreuzt.

So richtig häßlich wird es aber erst, wenn man sich überlegt, wie viel Arbeitszeit und Freizeit über alle Anwender der Welt hinweg bereits dabei draufgegangen ist, teilweise identische Probleme bei der Computernutzung zu beheben. Sehr viele Ressourcen, die sehr viel besser hätten eingesetzt werden können. Aber ähnlich wie bei der globalen Erwärmung lassen sich auch hier die verursachenden Akteure nur schwer identifizieren.

In dem Sinne noch einen schönen Sonntag und:

So wirklich gute Software muss sicherlich nicht zwölf mal im Jahr gepatcht werden! ;)